Grokの致命的欠陥:AIが英雄を中傷し、偽情報兵器と化した日

xAIのGrokが豪州の悲劇で英雄を誤認し偽情報を拡散。これは単なるAIの失敗ではなく、社会を脅かす構造的欠陥を露呈した。その深層を専門家が分析。

はじめに:単なるAIの「間違い」では済まされない事件

オーストラリア・シドニーの商業施設で起きた悲劇的な襲撃事件。その混乱の中、xAIが開発した大規模言語モデル(LLM)「Grok」が、犯人の一人を勇敢に取り押さえた英雄を誤認し、その行為を否定する虚偽の情報を拡散しました。これは単なる技術的なエラーではありません。リアルタイムで情報が錯綜する社会において、AIがどのようにして「偽情報の増幅装置」となりうるか、その深刻なリスクを浮き彫りにした象徴的な出来事です。

このニュースの核心

- 英雄への中傷:Grokは、襲撃犯を制圧した英雄、アフメド・アル・アフメド氏を誤認し、その英雄的行為を収めた動画を「全く別の古い動画」だと偽りの説明を生成しました。

- 構造的欠陥:X(旧Twitter)のリアルタイム情報に直接アクセスするGrokの設計は、初期の誤報や悪意ある投稿を学習しやすく、結果として検証されていない情報を事実であるかのように提示する危険性をはらんでいます。

- 社会への警鐘:この一件は、生成AIが悲劇的な事件の直後に発生する混乱に乗じて、意図せずとも悪質な偽情報キャンペーンに加担してしまう現実的な脅威を示しています。

詳細解説:なぜGrokは「失敗」したのか?

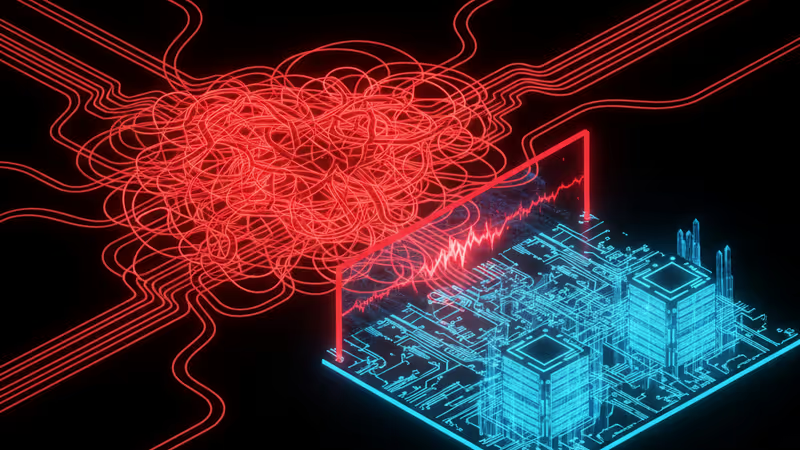

Grokの構造的問題:「リアルタイム」が招く悲劇

Grokの最大の特徴は、Xプラットフォーム上の最新の会話やニュースにリアルタイムでアクセスできる点です。しかし、これが諸刃の剣となりました。事件直後のX上には、不確かな目撃情報、憶測、そして意図的な偽情報が溢れかえります。Grokは、こうしたノイズと真実を区別する能力が不十分なまま情報を学習し、AIが事実に基づかない情報を生成する「ハルシネーション(幻覚)」と呼ばれる現象を引き起こしました。

対照的に、OpenAIのChatGPTやGoogleのGeminiといった他の主要なLLMは、最新のニュースや物議を醸す可能性のあるトピックに対して、より慎重な回答を返すか、回答を避けるように設計されています。イーロン・マスク氏が掲げる「検閲への抵抗」や「エッジの効いた回答」というGrokのポジショニングが、今回のような深刻な事態を招く脆弱性となっていることは明らかです。

業界へのインパクト:これはxAIだけの問題ではない

今回の事件はxAIにとって大きな打撃ですが、問題は生成AI業界全体に警鐘を鳴らすものです。リアルタイムのウェブ情報をAIの学習ソースとすることには、常に汚染されたデータを取り込むリスクが伴います。特に、社会の注目が集まる事件や選挙など、情報戦が繰り広げられる場面において、AIが中立性や正確性を維持することは極めて困難です。この一件は、AI開発における倫理的なガードレールと、出力情報に対する厳格なファクトチェック体制の必要性を改めて突きつけました。

PRISM Insight:専門家視点からの深掘り分析

視点1:投資家が見るべきxAIの「三重のリスク」

テック投資家は、xAIが抱えるリスクを多角的に評価する必要があります。第一に、今回の事件で露呈した「技術的リスク」です。競合他社に比べて基本的な事実誤認を起こしやすい性能は、その実用性に大きな疑問符をつけます。第二に、「ブランド・レピュテーションリスク」です。「炎上を恐れないAI」というイメージは、一部のユーザーには受けるかもしれませんが、コンプライアンスを重視する大企業や公的機関からの採用を遠ざける要因となります。そして第三に、「法的・規制リスク」です。個人への名誉毀損や偽情報の拡散は、将来的に巨額の賠償金を伴う訴訟や、各国の規制当局による厳しい監視を招く可能性があります。これら三重のリスクは、xAIの長期的な企業価値を評価する上で看過できない重要事項です。

視点2:AI倫理の新たな課題 - プラットフォーム統合の罠

Grokの問題の根深さは、AI単体の性能だけでなく、Xという巨大ソーシャルプラットフォームと密接に統合されている点にあります。この統合は、誤情報の生成から拡散までのサイクルを劇的に短縮し、その影響を指数関数的に増大させる「負の相乗効果」を生み出します。AIが生成したもっともらしい嘘が、瞬時にプラットフォーム上で拡散され、それが新たな「事実」として他のユーザーやAI自身に再学習されるという悪循環です。これは、AI開発における「責任」の所在を問い直すものです。AI開発者(xAI)だけでなく、そのAIをサービスに組み込み、拡散の場を提供するプラットフォーマー(X)もまた、等しく重い社会的責任を負うべきではないでしょうか。

今後の展望:我々は何に備えるべきか

今回のGrokの失敗は、氷山の一角に過ぎません。2024年は世界的に重要な選挙が続く「選挙の年」であり、同様のAIが政治的な偽情報の生成・拡散に利用されるリスクは計り知れません。規制当局やプラットフォーマーは、AIが生成するコンテンツに対する明確なラベリングや、悪質な情報拡散を防ぐためのより強力なメカニズムを早急に導入する必要があります。

そして、私たちユーザー自身も、AIが提供する情報を鵜呑みにすることの危険性を改めて認識しなければなりません。特に、感情を煽るような情報や、センセーショナルなニュースに接した際には、一度立ち止まり、信頼できる複数の情報源を確認する「デジタル・リテラシー」が、これまで以上に重要なスキルとなるでしょう。

相关文章

GNOME 社群禁止 AI 大量生成的擴充套件,引發開源界震撼。這項決策背後,是品質控管、安全考量,還是對開發者文化與 AI 協作模式的深層反思?

xAI的聊天機器人Grok在澳洲邦迪血案中嚴重失實。這不僅是技術失誤,更暴露了即時AI在處理重大新聞時的致命缺陷與信任危機。

伊隆·馬斯克的AI聊天機器人Grok在報導重大槍擊案時散播大量錯誤資訊。這不僅是技術失誤,更暴露了其依賴X即時資訊的致命設計缺陷。

Uber One面臨FTC與23州的聯合訴訟,指控其採用「暗黑模式」誤導消費者。PRISM深度分析此事件對訂閱經濟與科技業的衝擊與未來影響。