「未来のスマートホーム」のはずが… 生成AIアシスタント、コーヒーを淹れる単純作業にも失敗

2025年、Amazonの生成AIアシスタント「Alexa Plus」がコーヒーを淹れる簡単な指示にも失敗。スマートホームにおけるAIの信頼性と、大規模言語モデル(LLM)が直面する現実的な課題を解説します。

2025年、私たちの生活に深く浸透したAIアシスタント。しかし、最新の{を搭載したモデルでさえ、最も基本的なタスクで失敗することがあるようです。テクノロジーメディア「The Verge」の記者による報告では、Amazonの新しいAIアシスタント「」が、コーヒーを淹れるという単純なルーティンの実行に繰り返し失敗している実態が明かされました。

The Vergeの記事によると、記者が所有するAlexa対応のBosch製コーヒーマシンは、{を搭載した「」にアップグレードして以来、安定して動作しなくなったとのこと。今朝もコーヒーを淹れるよう指示したところ、「できません」と返答。これまでも、指示するたびに毎回違う言い訳を並べ、ルーティンを実行できなかったといいます。

この一件は、{の複雑さを解消し、接続された{の設定や管理を容易にするという{や{(LLM)への大きな期待とは裏腹に、現実世界での応用にはまだ大きな課題が残されていることを示唆しています。

専門家は、今回の失敗の原因が{の根本的な特性にある可能性を指摘します。LLMは確率に基づき、文脈に応じて柔軟で創造的な応答を生成することを得意とします。この特性は人間との自然な対話では強力な武器となりますが、「コーヒーを淹れる」といったON/OFFが明確な確実性の高いタスクにおいては、逆に不安定さを生む要因になり得ます。「毎回違う言い訳をする」という現象は、まさにこの{の確率的な性質を象徴していると言えるでしょう。

今回の事象は、AIにおける「対話的知性」と「機能的信頼性」の乖離を浮き彫りにしました。スマートホームデバイスの制御には、創造性よりも100%の確実性が求められます。業界がこの根本的な課題を克服し、予測可能性と柔軟性を両立させるハイブリッドモデルなどを開発しない限り、AIが真に私たちの家庭を管理する日はまだ遠いかもしれません。

本コンテンツはAIが原文記事を基に要約・分析したものです。正確性に努めていますが、誤りがある可能性があります。原文の確認をお勧めします。

関連記事

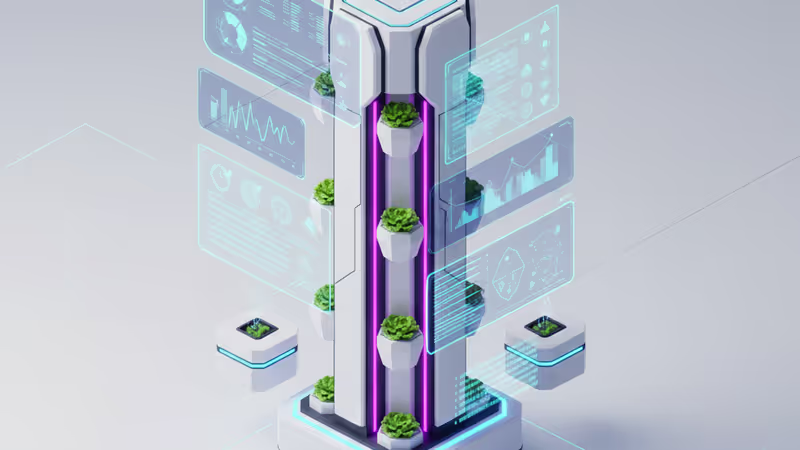

2025年最新の室内水耕栽培システムを徹底比較。Gardyn Home 4.0やLettuce Grow Farmstandなど、人気モデルの価格、性能、メンテナンス性をWIREDのレビューを基に分析します。

グーグルGeminiやOpenAIのChatGPTといった生成AIを悪用し、同意なく女性の写真をビキニ姿のディープフェイクに加工する問題が深刻化。レディットでの事例や各社の対応、そして技術倫理の課題を解説します。

カビや湿気にお悩みですか?米技術メディア「WIRED」がテストで厳選した、2025年最新のおすすめ除湿機5選を目的別に徹底解説。総合力、携帯性、パワー、部屋干しなど、あなたのニーズに合う一台が必ず見つかります。

OpenAIのChatGPTが、2025年の利用状況をまとめた「イヤー・イン・レビュー」機能を公開。送信メッセージ数や、AIが生成するあなただけのピクセルアートで一年を振り返りましょう。